Tendința de a crea păpuși digitale cu ajutorul inteligenței artificiale devine virală, însă riscurile pentru confidențialitatea utilizatorilor sunt reale și crescute dacă ne gândim la modul în care informațiile personale sunt expuse și exploatabile. Dincolo de aspectul ludic, folosirea unor instrumente precum ChatGPT pentru a genera versiuni stilizate de „action figure” ale propriei persoane poate oferi hackerilor exact genul de detalii de care au nevoie pentru atacuri de tip social engineering.

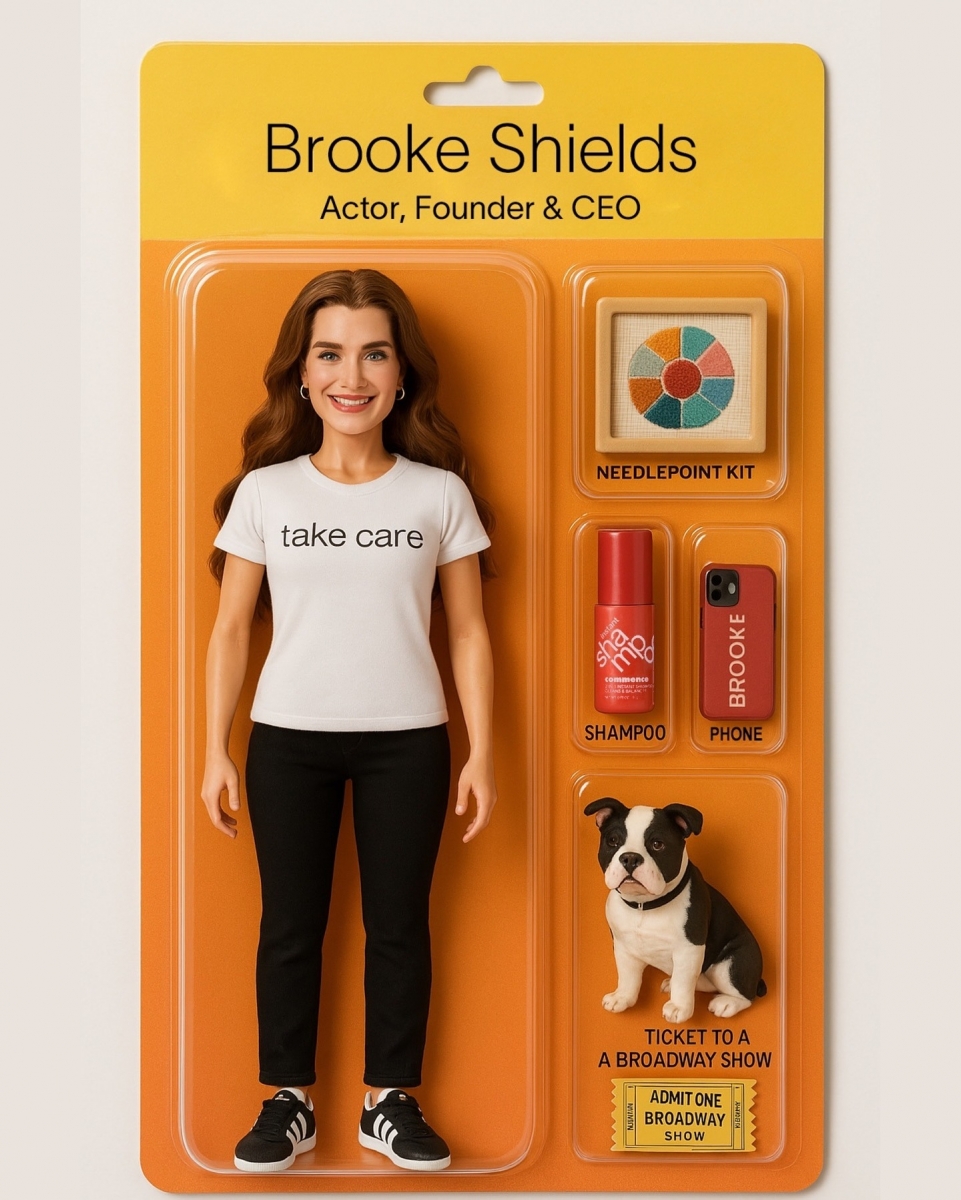

Totul începe cu un prompt aparent inofensiv: încarci o poză și soliciți modelarea unei figurine care să-ți semene și să reflecte pasiunile tale. Rezultatul – o păpușă în miniatură, adesea însoțită de „accesorii” precum o pisică, un bilet la teatru sau o unealtă de grădinărit – devine rapid o postare virală. Însă, după cum avertizează specialiștii în securitate cibernetică, aceste detalii pot transforma utilizatorii în ținte ușoare pentru atacuri personalizate.

Dave Chronister, directorul executiv al companiei de securitate informatică Parameter Security, subliniază faptul că „atunci când arăți lumii ce te interesează cel mai mult, devii vulnerabil în fața unor atacuri care exploatează emoțiile și interesele personale”. De exemplu, un escroc poate concepe un e-mail care pare a fi despre o ofertă legată de pisici portocalii, iar persoana care a menționat o astfel de pasiune într-o postare poate fi tentată să dea click fără să bănuiască nimic.

Problema nu se oprește însă la conținutul public. Există și o dimensiune mai puțin vizibilă: imaginea ta și datele introduse pot fi folosite pentru antrenarea viitoarelor modele AI. Jennifer King, cercetătoare în domeniul politicilor de date la Institutul Stanford pentru Inteligență Artificială Centrată pe Om, atrage atenția asupra faptului că, în mod implicit, conținutul introdus în ChatGPT este stocat și reutilizat dacă utilizatorii nu dezactivează în mod expres această opțiune. Mulți nici nu știu că pot face asta.

Această lipsă de control clar asupra modului în care datele sunt folosite ridică semne de întrebare etice și legale. Deși OpenAI susține că nu utilizează conținutul pentru profilare publicitară, ci doar pentru îmbunătățirea modelelor, lipsa transparenței în ce privește utilizările viitoare reprezintă o vulnerabilitate majoră.

Chronister avertizează că această tendință aparent banală este „un teren alunecos”, în care utilizatorii se obișnuiesc să ofere tot mai multe informații personale, pierzând din vedere consecințele pe termen lung. Ceea ce pare azi un simplu gest de divertisment poate deveni, mâine, o breșă de securitate.

Pentru cei care nu vor să renunțe la distracție, experții recomandă prudență sporită:

- evitați să includeți în aceste păpuși hobby-uri foarte specifice,

- nume de animale de companie,

- obiecte legate de stilul de viață sau bilete la evenimente.

- În plus, verificați setările de confidențialitate ale aplicației folosite și dezactivați opțiunea de a permite folosirea datelor pentru antrenarea AI.